网络抓取初步

网络爬虫初步

- 透过requets获取网络数据

- API

例子httpcat API使用

httpcat是个有趣的免费API,根据输入的http status code,返回一张cat图片

#https://httpcats.com/[http_status_code].jpg

import requests

# Set the URL of the image you want to download

url = "https://httpcats.com/404.jpg"

# Send a GET request to the URL and get the response

response = requests.get(url)

# Get the content of the response (i.e., the image data)

image_data = response.content

# Save the image to a file

with open("cat.jpg", "wb") as file:

file.write(image_data)

# Open the image file

image = Image.open("cat.jpg")

# Display the image

image.show()

当客户端向服务器发送请求时,服务器会返回一个状态码来指示请求的处理结果。以下是一些常见的HTTP状态码的列表:

1xx(信息性状态码):这些状态码表示服务器已经收到了请求并正在继续处理它。例如:

100(继续):服务器已经收到了请求头部,客户端应该继续发送请求主体。

101(切换协议):服务器正在更改协议,例如从HTTP到WebSocket。

2xx(成功状态码):这些状态码表示服务器已经成功接收、理解和处理了请求。例如:200(成功):请求已成功处理。 201(已创建):请求已成功处理,并创建了一个新的资源。

204(无内容):请求已成功处理,但没有内容返回。 3xx(重定向状态码):这些状态码表示客户端必须采取其他操作才能完成请求。例如:301(永久移动):请求的资源已永久移动到一个新的URL。 302(临时移动):请求的资源已在不同的URL找到,但位置可能是临时的。

304(未修改):客户端缓存的资源副本仍然有效。 4xx(客户端错误状态码):这些状态码表示客户端在请求中出现了错误。例如:400(错误请求):由于语法格式不正确,服务器无法理解请求。 401(未经授权):客户端必须进行身份验证才能获取所请求的响应。

403(禁止访问):客户端没有访问内容的权限。 5xx(服务器错误状态码):这些状态码表示服务器在处理请求时遇到了错误。例如:500(服务器内部错误):服务器遇到了意外的条件,阻止它完成请求。 502(错误网关):服务器作为网关或代理时从上游服务器收到了无效的响应。

503(服务不可用):服务器当前由于临时超载或维护而无法处理请求。

拓展练习:

增加用户输入

根据输入获取对应的图片,用该输入命名图片文件,比如404.jpg, 101.jpg 等等

import requests

from PIL import Image

http_status_code = 101

http_status_code = input('Input 3 digits HTTP STATUS CODE(like 101, 404 etc):')

# Set the URL of the image you want to download

url = f"https://httpcats.com/{http_status_code}.jpg"

# Send a GET request to the URL and get the response

response = requests.get(url)

# Get the content of the response (i.e., the image data)

image_data = response.content

# Save the image to a file

with open(f"{http_status_code}.jpg", "wb") as file:

file.write(image_data)

# Open the image file

image = Image.open(f"{http_status_code}.jpg")

# Display the image

image.show()

另外更高阶的话题,可以使用selenium实现网络访问自动化

使用selenium我实现了一个自动抓取网络数据的小工具

补充材料

Extra Topic 网络数据抓取

网络爬虫是一种自动化程序,用于从互联网上收集信息。它模仿人类在浏览器中浏览网页的行为,通过访问网站并提取感兴趣的数据。

使用Python编写网络爬虫非常方便,你可以使用Python中的一些库(例如Requests和Beautiful Soup)来帮助你完成这个任务。下面是一个简单的步骤指南,帮助你了解如何使用Python来从网站上提取数据:

1. 安装Python:首先,确保你的计算机上安装了Python编程语言。你可以从Python官方网站(https://www.python.org)上下载并安装最新版本的Python。

2. 安装所需的库:在Python中,有一些非常有用的库可以帮助你进行网络爬虫。其中两个常用的库是Requests和Beautiful Soup。你可以使用以下命令在终端或命令提示符中安装它们:

pip install requests

pip install beautifulsoup4

导入所需的库:在你的Python代码中,首先导入这些库,以便你可以使用它们的功能。例如:

import requests

from bs4 import BeautifulSoup

发起HTTP请求:使用Requests库,你可以发送HTTP请求以获取网页的内容。你可以使用以下代码发送一个简单的GET请求:

response = requests.get('https://www.example.com')

这将返回一个包含响应内容的对象。

1. 解析网页内容:使用Beautiful Soup库,你可以解析网页的内容,以便提取你感兴趣的数据。你可以使用以下代码创建一个Beautiful Soup对象,并使用其功能来解析网页:

soup = BeautifulSoup(response.content, 'html.parser')

提取数据:通过分析网页的HTML结构,你可以使用Beautiful Soup提供的方法来提取数据。你可以使用标签名称、CSS选择器、类名等等来定位和提取数据。以下是一个简单的示例:

假设网页中有一个 标签,类名为 "content"div_element = soup.find('div', class_='content')

提取该 标签中的文本内容content = div_element.text

这是一个简单的例子,你可以根据网页的结构和你的需求来提取更多的数据。

这是一个初步的介绍,帮助你了解网络爬虫的概念以及如何使用Python从网站上提取数据。当你进一步学习和实践时,你会发现还有很多关于网络爬虫的技术和策略可以探索。记住,在使用网络爬虫时要遵守网站的使用规则和法律法规,确保

例子,抓取dazuicheng.com上博客文章

import requests

from bs4 import BeautifulSoup

# 发起HTTP请求获取网页内容

url = 'http://www.dazuicheng.com'

#url = 'http://www.dazuicheng.com/index.php/page/2/' # 要抓取的网站地址, next page

response = requests.get(url)

# 解析网页内容

soup = BeautifulSoup(response.content, 'html.parser')

# 提取博客文章

articles = soup.find_all('article')

# 打印博客文章标题和内容

for article in articles:

title = article.find('h2').text.strip()

content = article.find('div', class_='post-content').text.strip()

print('标题:', title)

print('内容:', content)

print('---')

构建一个简单的工具-网络数据抓取

需求

从特定网站抓取数据,存入exel文件! 因为有几万条,并且这些数据定期会更新,人工抓取显然效率太低了,所以有必要编写一些简单的工具自动抓取

目前这些网站数据免费,也不需要注册,处理器起来比较简单,有一些可能还需要验证码稍微复杂一些

但实现的基本思路都是一样的,只要人能做标准化流程的,机器就能自动化实现;人工重复操作的,有必要实现程序自动化

基本思路

- 使用selenium模拟浏览器操作

- OpenCV图形处理,验证码识别与匹配

- selenium控制浏览器,模拟鼠标、键盘操作

- 最后用PyQt6包装个GUI界面,让一般用户也比较好使用

- 最最后一步就是使用pyinstaller,将python脚本打造成可以独立运行的程序

python脚本好处是跨平台,同样的代码在Linux,Windows,Mac上都可以运行,同样用pyinstaller分别打包不同平台的独立可执行程序,分发给普通用户使用,非常便利

实现效果

只是普通的工具,所以也没有所谓漂亮的外表,简单易用就好,开始没想好,界面上多了一些无用的组件,暂时没有禁止;实际使用也就涉及2~3次点击,即可抓取需要的数据

编写类似小工具,稳定性、速度、普通用户使用便捷性是我主要考虑的三大要素

实现过程

为了生产率,就算这样简单的小工具,也不应该重零开始编写;最近ChatGPT非常火,我也一直在使用,所以自然第一次接收到这个需求,我就想到使用#AGI帮助我完成;结果是显而易见的,感觉至少10x生产力提升

- 首先,第一次接触网络数据抓取实际开发,虽然有所了解,但毕竟不是这方面的专家,透过和AGI聊天,我快速熟悉了selenium

- 其次,让ChatGPT使用PyQt帮助我构建了GUI的几乎全部代码,剩下的就是一些简单的微调

- 最后,透过ChatGPT聊天,熟悉了如何处理验证码,目前只处理了slider (滑动)验证码 - 移动拼图

涉及这三部分技术,如果靠传统的搜索,我也能搞定,但明显效率不会如此之高。 第一次给出的GUI代码,基本上就没有修改,直接能用,并且我只是使用很自然的语言,比如:

使用PyQt6构建这样一个GUI应用,包含两个combox,一个里面输入网址,‘xxxx1.com’, 'xxxx2.com'等等,一个combox输入设备类型,比如‘起重机’,‘吊车’ 等等,包含一个程序日志输出窗口,包含一个按钮...

对于selenium模块的使用,一开始并不知道这个东西的存在

selenium自动化操作浏览器

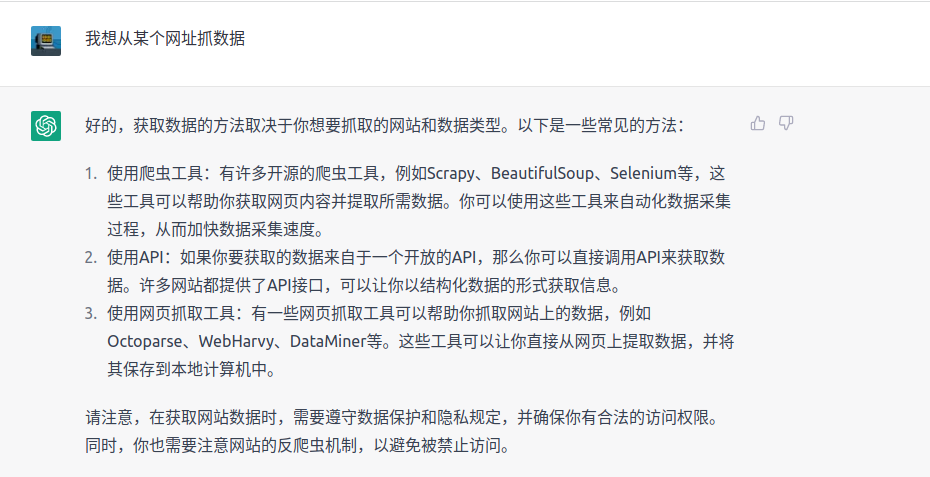

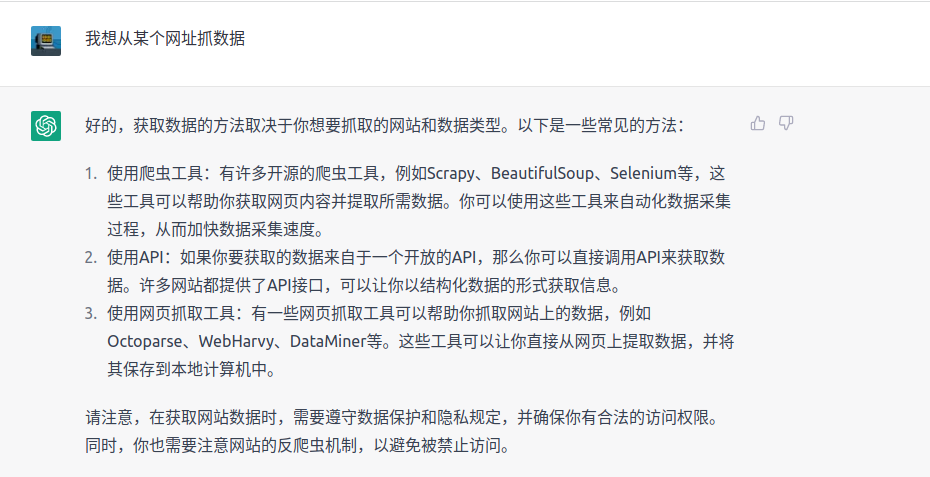

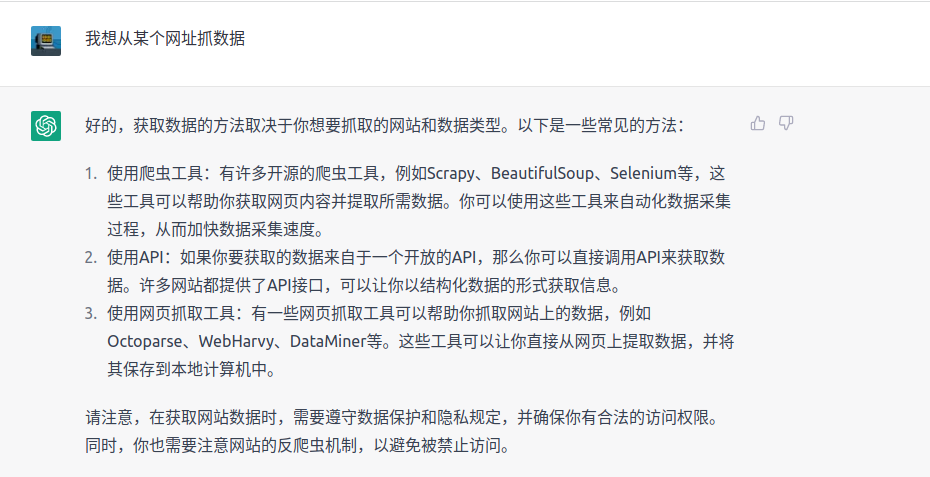

关于网络数据抓取,给ChatGPT的第一个问题是:

>我想编写python脚本,自动抓取某个特定网址的数据

balabal...

ChatGPT就给我输出一大堆相关的背景知识

我接下来是要求给一些代码,这样我可以快速 验证

模拟鼠标点击、选择的问题发出之后,很快selenium就进入了视野

比如我想定位网页上某个元素,比如‘查找按钮’、‘下一页’或者‘跳转’按钮等,这些AGI都能直接给出答案

opencv验证码处理

基本的思路是图形处理,轮廓识别与匹配

这部分可能是最花时间的,有一定的技术门槛,细节以后再深入探讨

PyQt6与pyinstaller

使用ChatGPT构建GUI确实非常方便,不过给出的一些例子代码可能有版本匹配的问题,不过如果出现类似错误,直接将错误作为问题继续对ChatGPT提问,往往很容易得到答案,如果经过几次尝试得不到答案,我一般还是选择人工google一下(这种情况有,不是很多)

小结:

这个工具断断续续利用周末的时间不断完善,也花了好几天,其实第一次使用ChatGPT基本构建了程序的原型,后面的工作主要作了一些优化:

- 增加程序的稳定性,出错的处理和重试机制

- 分块抓取,多线程抓取

另外还有一个坑,最开始使用PyQt5,使用pyinstaller打包始终不成功,大概率是opencv相关的版本冲突导致,果断切换到PyQt6,顺利解决问题

使用ChatGPT解决编写代码的问题,相关的prompt engineering 也是有一定的模式可遵循,多多练习就能让ChatGPT快速、精准提供可用的答案

div_element = soup.find('div', class_='content')

提取该 标签中的文本内容content = div_element.text

这是一个简单的例子,你可以根据网页的结构和你的需求来提取更多的数据。

这是一个初步的介绍,帮助你了解网络爬虫的概念以及如何使用Python从网站上提取数据。当你进一步学习和实践时,你会发现还有很多关于网络爬虫的技术和策略可以探索。记住,在使用网络爬虫时要遵守网站的使用规则和法律法规,确保

例子,抓取dazuicheng.com上博客文章

import requests

from bs4 import BeautifulSoup

# 发起HTTP请求获取网页内容

url = 'http://www.dazuicheng.com'

#url = 'http://www.dazuicheng.com/index.php/page/2/' # 要抓取的网站地址, next page

response = requests.get(url)

# 解析网页内容

soup = BeautifulSoup(response.content, 'html.parser')

# 提取博客文章

articles = soup.find_all('article')

# 打印博客文章标题和内容

for article in articles:

title = article.find('h2').text.strip()

content = article.find('div', class_='post-content').text.strip()

print('标题:', title)

print('内容:', content)

print('---')

构建一个简单的工具-网络数据抓取

需求

从特定网站抓取数据,存入exel文件! 因为有几万条,并且这些数据定期会更新,人工抓取显然效率太低了,所以有必要编写一些简单的工具自动抓取

目前这些网站数据免费,也不需要注册,处理器起来比较简单,有一些可能还需要验证码稍微复杂一些

但实现的基本思路都是一样的,只要人能做标准化流程的,机器就能自动化实现;人工重复操作的,有必要实现程序自动化

基本思路

- 使用selenium模拟浏览器操作

- OpenCV图形处理,验证码识别与匹配

- selenium控制浏览器,模拟鼠标、键盘操作

- 最后用PyQt6包装个GUI界面,让一般用户也比较好使用

- 最最后一步就是使用pyinstaller,将python脚本打造成可以独立运行的程序

python脚本好处是跨平台,同样的代码在Linux,Windows,Mac上都可以运行,同样用pyinstaller分别打包不同平台的独立可执行程序,分发给普通用户使用,非常便利

实现效果

只是普通的工具,所以也没有所谓漂亮的外表,简单易用就好,开始没想好,界面上多了一些无用的组件,暂时没有禁止;实际使用也就涉及2~3次点击,即可抓取需要的数据

编写类似小工具,稳定性、速度、普通用户使用便捷性是我主要考虑的三大要素

实现过程

为了生产率,就算这样简单的小工具,也不应该重零开始编写;最近ChatGPT非常火,我也一直在使用,所以自然第一次接收到这个需求,我就想到使用#AGI帮助我完成;结果是显而易见的,感觉至少10x生产力提升

- 首先,第一次接触网络数据抓取实际开发,虽然有所了解,但毕竟不是这方面的专家,透过和AGI聊天,我快速熟悉了selenium

- 其次,让ChatGPT使用PyQt帮助我构建了GUI的几乎全部代码,剩下的就是一些简单的微调

- 最后,透过ChatGPT聊天,熟悉了如何处理验证码,目前只处理了slider (滑动)验证码 - 移动拼图

涉及这三部分技术,如果靠传统的搜索,我也能搞定,但明显效率不会如此之高。 第一次给出的GUI代码,基本上就没有修改,直接能用,并且我只是使用很自然的语言,比如:

使用PyQt6构建这样一个GUI应用,包含两个combox,一个里面输入网址,‘xxxx1.com’, 'xxxx2.com'等等,一个combox输入设备类型,比如‘起重机’,‘吊车’ 等等,包含一个程序日志输出窗口,包含一个按钮...

对于selenium模块的使用,一开始并不知道这个东西的存在

selenium自动化操作浏览器

关于网络数据抓取,给ChatGPT的第一个问题是:

>我想编写python脚本,自动抓取某个特定网址的数据

balabal...

ChatGPT就给我输出一大堆相关的背景知识

我接下来是要求给一些代码,这样我可以快速 验证

模拟鼠标点击、选择的问题发出之后,很快selenium就进入了视野

比如我想定位网页上某个元素,比如‘查找按钮’、‘下一页’或者‘跳转’按钮等,这些AGI都能直接给出答案

opencv验证码处理

基本的思路是图形处理,轮廓识别与匹配

这部分可能是最花时间的,有一定的技术门槛,细节以后再深入探讨

PyQt6与pyinstaller

使用ChatGPT构建GUI确实非常方便,不过给出的一些例子代码可能有版本匹配的问题,不过如果出现类似错误,直接将错误作为问题继续对ChatGPT提问,往往很容易得到答案,如果经过几次尝试得不到答案,我一般还是选择人工google一下(这种情况有,不是很多)

小结:

这个工具断断续续利用周末的时间不断完善,也花了好几天,其实第一次使用ChatGPT基本构建了程序的原型,后面的工作主要作了一些优化:

- 增加程序的稳定性,出错的处理和重试机制

- 分块抓取,多线程抓取

另外还有一个坑,最开始使用PyQt5,使用pyinstaller打包始终不成功,大概率是opencv相关的版本冲突导致,果断切换到PyQt6,顺利解决问题

使用ChatGPT解决编写代码的问题,相关的prompt engineering 也是有一定的模式可遵循,多多练习就能让ChatGPT快速、精准提供可用的答案

content = div_element.text

这是一个简单的例子,你可以根据网页的结构和你的需求来提取更多的数据。

这是一个初步的介绍,帮助你了解网络爬虫的概念以及如何使用Python从网站上提取数据。当你进一步学习和实践时,你会发现还有很多关于网络爬虫的技术和策略可以探索。记住,在使用网络爬虫时要遵守网站的使用规则和法律法规,确保

例子,抓取dazuicheng.com上博客文章

import requests

from bs4 import BeautifulSoup# 发起HTTP请求获取网页内容

url = 'http://www.dazuicheng.com'

#url = 'http://www.dazuicheng.com/index.php/page/2/' # 要抓取的网站地址, next page

response = requests.get(url)# 解析网页内容

soup = BeautifulSoup(response.content, 'html.parser')# 提取博客文章

articles = soup.find_all('article')# 打印博客文章标题和内容

for article in articles:title = article.find('h2').text.strip() content = article.find('div', class_='post-content').text.strip() print('标题:', title) print('内容:', content) print('---')

构建一个简单的工具-网络数据抓取

需求

从特定网站抓取数据,存入exel文件! 因为有几万条,并且这些数据定期会更新,人工抓取显然效率太低了,所以有必要编写一些简单的工具自动抓取

目前这些网站数据免费,也不需要注册,处理器起来比较简单,有一些可能还需要验证码稍微复杂一些

但实现的基本思路都是一样的,只要人能做标准化流程的,机器就能自动化实现;人工重复操作的,有必要实现程序自动化

基本思路

- 使用selenium模拟浏览器操作

- OpenCV图形处理,验证码识别与匹配

- selenium控制浏览器,模拟鼠标、键盘操作

- 最后用PyQt6包装个GUI界面,让一般用户也比较好使用

- 最最后一步就是使用pyinstaller,将python脚本打造成可以独立运行的程序

python脚本好处是跨平台,同样的代码在Linux,Windows,Mac上都可以运行,同样用pyinstaller分别打包不同平台的独立可执行程序,分发给普通用户使用,非常便利

实现效果

只是普通的工具,所以也没有所谓漂亮的外表,简单易用就好,开始没想好,界面上多了一些无用的组件,暂时没有禁止;实际使用也就涉及2~3次点击,即可抓取需要的数据

编写类似小工具,稳定性、速度、普通用户使用便捷性是我主要考虑的三大要素

实现过程

为了生产率,就算这样简单的小工具,也不应该重零开始编写;最近ChatGPT非常火,我也一直在使用,所以自然第一次接收到这个需求,我就想到使用#AGI帮助我完成;结果是显而易见的,感觉至少10x生产力提升

- 首先,第一次接触网络数据抓取实际开发,虽然有所了解,但毕竟不是这方面的专家,透过和AGI聊天,我快速熟悉了selenium

- 其次,让ChatGPT使用PyQt帮助我构建了GUI的几乎全部代码,剩下的就是一些简单的微调

- 最后,透过ChatGPT聊天,熟悉了如何处理验证码,目前只处理了slider (滑动)验证码 - 移动拼图

涉及这三部分技术,如果靠传统的搜索,我也能搞定,但明显效率不会如此之高。 第一次给出的GUI代码,基本上就没有修改,直接能用,并且我只是使用很自然的语言,比如:

使用PyQt6构建这样一个GUI应用,包含两个combox,一个里面输入网址,‘xxxx1.com’, 'xxxx2.com'等等,一个combox输入设备类型,比如‘起重机’,‘吊车’ 等等,包含一个程序日志输出窗口,包含一个按钮...

对于selenium模块的使用,一开始并不知道这个东西的存在

selenium自动化操作浏览器

关于网络数据抓取,给ChatGPT的第一个问题是:

>我想编写python脚本,自动抓取某个特定网址的数据

balabal...

ChatGPT就给我输出一大堆相关的背景知识

我接下来是要求给一些代码,这样我可以快速 验证

模拟鼠标点击、选择的问题发出之后,很快selenium就进入了视野

比如我想定位网页上某个元素,比如‘查找按钮’、‘下一页’或者‘跳转’按钮等,这些AGI都能直接给出答案

opencv验证码处理

基本的思路是图形处理,轮廓识别与匹配

这部分可能是最花时间的,有一定的技术门槛,细节以后再深入探讨

PyQt6与pyinstaller

使用ChatGPT构建GUI确实非常方便,不过给出的一些例子代码可能有版本匹配的问题,不过如果出现类似错误,直接将错误作为问题继续对ChatGPT提问,往往很容易得到答案,如果经过几次尝试得不到答案,我一般还是选择人工google一下(这种情况有,不是很多)

小结:

这个工具断断续续利用周末的时间不断完善,也花了好几天,其实第一次使用ChatGPT基本构建了程序的原型,后面的工作主要作了一些优化:

- 增加程序的稳定性,出错的处理和重试机制

- 分块抓取,多线程抓取

另外还有一个坑,最开始使用PyQt5,使用pyinstaller打包始终不成功,大概率是opencv相关的版本冲突导致,果断切换到PyQt6,顺利解决问题

使用ChatGPT解决编写代码的问题,相关的prompt engineering 也是有一定的模式可遵循,多多练习就能让ChatGPT快速、精准提供可用的答案